Prueba TU Negocio en Minutos

Crea tu cuenta y lanza tu chatbot de IA en minutos. Totalmente personalizable, sin necesidad de código - ¡comienza a interactuar con tus clientes al instante!

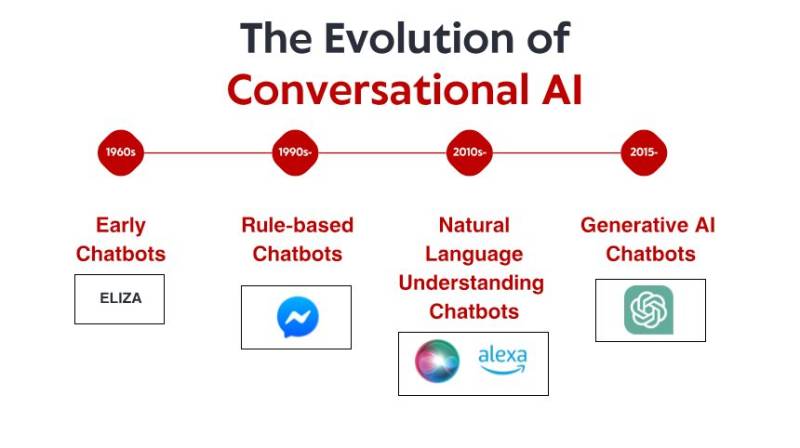

Los humildes comienzos: los primeros sistemas basados en reglas

Lo que hizo a ELIZA excepcional no fue su sofisticación técnica (para los estándares actuales, el programa era increíblemente básico). Más bien, fue el profundo efecto que tuvo en los usuarios. A pesar de saber que estaban hablando con un programa informático sin ninguna comprensión real, muchas personas establecieron conexiones emocionales con ELIZA, compartiendo pensamientos y sentimientos profundamente personales. Este fenómeno, que el propio Weizenbaum encontró inquietante, reveló algo fundamental sobre la psicología humana y nuestra disposición a antropomorfizar incluso las interfaces conversacionales más simples. A lo largo de las décadas de 1970 y 1980, los chatbots basados en reglas siguieron el modelo de ELIZA con mejoras graduales. Programas como PARRY (que simulaba un esquizofrénico paranoide) y RACTER (autor del libro "La barba del policía está a medio construir") se mantuvieron firmes dentro del paradigma basado en reglas, utilizando patrones predefinidos, coincidencia de palabras clave y respuestas predefinidas.

Estos primeros sistemas presentaban graves limitaciones. No podían comprender el lenguaje, aprender de las interacciones ni adaptarse a entradas inesperadas. Su conocimiento se limitaba a las reglas que sus programadores habían definido explícitamente. Cuando los usuarios, inevitablemente, se extraviaban de estos límites, la ilusión de inteligencia se desvanecía rápidamente, revelando la naturaleza mecánica subyacente. A pesar de estas limitaciones, estos sistemas pioneros sentaron las bases sobre las que se construiría toda la IA conversacional futura.

La revolución del conocimiento: sistemas expertos e información estructurada

Sistemas expertos como MYCIN (que diagnosticaba infecciones bacterianas) y DENDRAL (que identificaba compuestos químicos) organizaban la información en bases de conocimiento estructuradas y utilizaban motores de inferencia para extraer conclusiones. Al aplicarse a interfaces conversacionales, este enfoque permitió a los chatbots ir más allá de la simple coincidencia de patrones hacia algo similar al razonamiento, al menos en dominios específicos.

Las empresas comenzaron a implementar aplicaciones prácticas, como sistemas automatizados de atención al cliente, utilizando esta tecnología. Estos sistemas solían utilizar árboles de decisión e interacciones basadas en menús en lugar de conversaciones libres, pero representaron los primeros intentos de automatizar interacciones que anteriormente requerían intervención humana.

Las limitaciones seguían siendo significativas. Estos sistemas eran frágiles, incapaces de gestionar entradas inesperadas con fluidez. Requerían un enorme esfuerzo por parte de los ingenieros de conocimiento para codificar manualmente la información y las reglas. Y quizás lo más importante, aún no podían comprender plenamente el lenguaje natural en toda su complejidad y ambigüedad.

Sin embargo, esta era estableció conceptos importantes que posteriormente serían cruciales para la IA conversacional moderna: la representación estructurada del conocimiento, la inferencia lógica y la especialización de dominios. Se estaba preparando el escenario para un cambio de paradigma, aunque la tecnología aún no estaba completamente desarrollada.

Comprensión del lenguaje natural: el avance de la lingüística computacional

Este cambio fue posible gracias a varios factores: mayor potencia computacional, mejores algoritmos y, fundamentalmente, la disponibilidad de grandes corpus textuales que podían analizarse para identificar patrones lingüísticos. Los sistemas comenzaron a incorporar técnicas como:

Etiquetado de categorías gramaticales: Identificar si las palabras funcionaban como sustantivos, verbos, adjetivos, etc.

Reconocimiento de entidades con nombre: Detectar y clasificar nombres propios (personas, organizaciones, lugares).

Análisis de sentimientos: Determinar el tono emocional del texto.

Sintálamo: Analizar la estructura de las oraciones para identificar las relaciones gramaticales entre las palabras.

Un avance notable se produjo con Watson de IBM, que se hizo famoso al derrotar a los campeones humanos en el concurso de preguntas Jeopardy! En 2011. Si bien no era estrictamente un sistema conversacional, Watson demostró capacidades sin precedentes para comprender preguntas en lenguaje natural, buscar en vastos repositorios de conocimiento y formular respuestas; capacidades que resultarían esenciales para la próxima generación de chatbots.

Pronto le siguieron las aplicaciones comerciales. Siri de Apple se lanzó en 2011, acercando las interfaces conversacionales al consumidor general. Si bien limitada para los estándares actuales, Siri representó un avance significativo al hacer que los asistentes de IA fueran accesibles para los usuarios cotidianos. Cortana de Microsoft, el Asistente de Google y Alexa de Amazon le seguirían, cada uno impulsando la vanguardia de la IA conversacional orientada al consumidor.

A pesar de estos avances, los sistemas de esta época aún tenían dificultades con el contexto, el razonamiento de sentido común y la generación de respuestas que sonaran verdaderamente naturales. Eran más sofisticados que sus antecesores basados en reglas, pero seguían siendo fundamentalmente limitados en su comprensión del lenguaje y del mundo.

Aprendizaje automático y el enfoque basado en datos

Esta era presenció el auge de la clasificación de intenciones y la extracción de entidades como componentes esenciales de la arquitectura conversacional. Cuando un usuario realizaba una solicitud, el sistema:

Clasificaba la intención general (p. ej., reservar un vuelo, consultar el tiempo, reproducir música);

Extraía entidades relevantes (p. ej., ubicaciones, fechas, títulos de canciones);

Asignaba estas a acciones o respuestas específicas.

El lanzamiento de la plataforma Messenger de Facebook (ahora Meta) en 2016 permitió a los desarrolladores crear chatbots que podían llegar a millones de usuarios, lo que desató un gran interés comercial. Muchas empresas se apresuraron a implementar chatbots, aunque los resultados fueron dispares. Las primeras implementaciones comerciales a menudo frustraban a los usuarios debido a su comprensión limitada y a la rigidez de los flujos de conversación.

La arquitectura técnica de los sistemas conversacionales también evolucionó durante este período. El enfoque típico implicaba una secuencia de componentes especializados:

Reconocimiento automático de voz (para interfaces de voz)

Comprensión del lenguaje natural

Gestión de diálogos

Generación de lenguaje natural

Conversión de texto a voz (para interfaces de voz)

Cada componente podía optimizarse por separado, lo que permitía mejoras graduales. Sin embargo, estas arquitecturas de secuencias de comandos a veces sufrían de propagación de errores: los errores en las primeras etapas se propagaban en cascada por todo el sistema.

Si bien el aprendizaje automático mejoró significativamente las capacidades, los sistemas aún tenían dificultades para mantener el contexto durante conversaciones largas, comprender la información implícita y generar respuestas verdaderamente diversas y naturales. El siguiente avance requeriría un enfoque más radical.

La revolución de los transformadores: modelos de lenguaje neuronal

Esta innovación permitió el desarrollo de modelos lingüísticos cada vez más potentes. En 2018, Google introdujo BERT (Representaciones de Codificador Bidireccional de Transformers), que mejoró drásticamente el rendimiento en diversas tareas de comprensión del lenguaje. En 2019, OpenAI lanzó GPT-2, demostrando capacidades sin precedentes para generar texto coherente y contextualmente relevante.

El salto más drástico se produjo en 2020 con GPT-3, que escaló hasta 175 000 millones de parámetros (en comparación con los 1500 millones de GPT-2). Este enorme aumento de escala, combinado con mejoras arquitectónicas, produjo capacidades cualitativamente diferentes. GPT-3 podía generar textos con una similitud notable con el humano, comprender el contexto de miles de palabras e incluso realizar tareas para las que no había sido entrenado explícitamente.

Para la IA conversacional, estos avances se tradujeron en chatbots capaces de:

Mantener conversaciones coherentes a lo largo de varios turnos

Comprender consultas con matices sin entrenamiento explícito

Generar respuestas diversas y contextualmente apropiadas

Adaptar su tono y estilo al usuario

Manejar la ambigüedad y aclarar cuando fuera necesario

El lanzamiento de ChatGPT a finales de 2022 popularizó estas capacidades, atrayendo a más de un millón de usuarios a los pocos días de su lanzamiento. De repente, el público general tuvo acceso a una IA conversacional que parecía cualitativamente diferente a todo lo anterior: más flexible, con mayor conocimiento y con interacciones más naturales.

Las implementaciones comerciales se sucedieron rápidamente, y las empresas incorporaron amplios modelos de lenguaje en sus plataformas de atención al cliente, herramientas de creación de contenido y aplicaciones de productividad. La rápida adopción reflejó tanto el avance tecnológico como la interfaz intuitiva que proporcionaban estos modelos; después de todo, la conversación es la forma más natural de comunicarse para los humanos.

Prueba TU Negocio en Minutos

Crea tu cuenta y lanza tu chatbot de IA en minutos. Totalmente personalizable, sin necesidad de código - ¡comienza a interactuar con tus clientes al instante!

Capacidades multimodales: más allá de las conversaciones de solo texto

Modelos de visión-lenguaje como DALL-E, Midjourney y Stable Diffusion demostraron la capacidad de generar imágenes a partir de descripciones textuales, mientras que modelos como GPT-4 con capacidades visuales podían analizar imágenes y analizarlas de forma inteligente. Esto abrió nuevas posibilidades para las interfaces conversacionales:

Bots de atención al cliente que pueden analizar fotos de productos dañados

Asistentes de compra que pueden identificar artículos a partir de imágenes y encontrar productos similares

Herramientas educativas que pueden explicar diagramas y conceptos visuales

Funciones de accesibilidad que pueden describir imágenes para usuarios con discapacidad visual

Las capacidades de voz también han avanzado drásticamente. Las primeras interfaces de voz, como los sistemas IVR (Respuesta de Voz Interactiva), eran notoriamente frustrantes, limitadas a comandos rígidos y estructuras de menú. Los asistentes de voz modernos pueden comprender patrones naturales del habla, tener en cuenta diferentes acentos e impedimentos del habla, y responder con voces sintetizadas cada vez más naturales.

La fusión de estas capacidades está creando una IA conversacional verdaderamente multimodal que puede cambiar sin problemas entre diferentes modos de comunicación según el contexto y las necesidades del usuario. Un usuario podría comenzar con una pregunta de texto sobre la reparación de su impresora, enviar una foto del mensaje de error, recibir un diagrama con los botones relevantes y luego cambiar a instrucciones de voz mientras realiza la reparación.

Este enfoque multimodal representa no solo un avance técnico, sino un cambio fundamental hacia una interacción persona-computadora más natural: conectar con los usuarios en el modo de comunicación que mejor se adapte a su contexto y necesidades actuales.

Generación aumentada por recuperación: la IA basada en hechos

La Generación Aumentada por Recuperación (RAG) surgió como una solución a estos desafíos. En lugar de depender únicamente de los parámetros aprendidos durante el entrenamiento, los sistemas RAG combinan las capacidades generativas de los modelos lingüísticos con mecanismos de recuperación que pueden acceder a fuentes de conocimiento externas. La arquitectura típica de RAG funciona así:

El sistema recibe una consulta del usuario.

Busca información relevante para la consulta en bases de conocimiento.

Alimenta al modelo de lenguaje con la consulta y la información recuperada.

El modelo genera una respuesta basada en los datos recuperados.

Este enfoque ofrece varias ventajas:

Respuestas más precisas y objetivas al basar la generación en información verificada.

Capacidad de acceder a información actualizada más allá del límite de entrenamiento del modelo.

Conocimiento especializado de fuentes específicas del dominio, como la documentación de la empresa.

Transparencia y atribución al citar las fuentes de información.

Para las empresas que implementan IA conversacional, RAG ha demostrado ser especialmente valioso para las aplicaciones de atención al cliente. Un chatbot bancario, por ejemplo, puede acceder a los documentos de políticas, información de cuentas y registros de transacciones más recientes para proporcionar respuestas precisas y personalizadas que serían imposibles con un modelo de lenguaje independiente. La evolución de los sistemas RAG continúa con mejoras en la precisión de recuperación, métodos más sofisticados para integrar la información recuperada con el texto generado y mejores mecanismos para evaluar la confiabilidad de diferentes fuentes de información.

El modelo de colaboración humano-IA: encontrar el equilibrio adecuado

Las implementaciones más exitosas hoy en día siguen un modelo colaborativo donde:

La IA gestiona consultas rutinarias y repetitivas que no requieren juicio humano.

Los humanos se centran en casos complejos que requieren empatía, razonamiento ético o resolución creativa de problemas.

El sistema conoce sus limitaciones y escala sin problemas a los agentes humanos cuando corresponde.

La transición entre la IA y el soporte humano es fluida para el usuario.

Los agentes humanos tienen un contexto completo del historial de conversaciones con la IA.

La IA continúa aprendiendo de las intervenciones humanas, ampliando gradualmente sus capacidades.

Este enfoque reconoce que la IA conversacional no debe aspirar a reemplazar por completo la interacción humana, sino a complementarla, gestionando las consultas directas y de gran volumen que consumen el tiempo de los agentes humanos, a la vez que garantiza que los problemas complejos lleguen a la experiencia humana adecuada. La implementación de este modelo varía según el sector. En el ámbito sanitario, los chatbots de IA podrían gestionar la programación de citas y la detección de síntomas básicos, garantizando al mismo tiempo que el asesoramiento médico provenga de profesionales cualificados. En el ámbito jurídico, la IA podría ayudar con la preparación e investigación de documentos, dejando la interpretación y la estrategia en manos de los abogados. En atención al cliente, la IA puede resolver problemas comunes y derivar los complejos a agentes especializados.

A medida que las capacidades de la IA sigan avanzando, la línea entre lo que requiere intervención humana y lo que puede automatizarse cambiará, pero el principio fundamental se mantiene: una IA conversacional eficaz debería mejorar las capacidades humanas en lugar de simplemente sustituirlas.

El panorama futuro: hacia dónde se dirige la IA conversacional

Personalización a escala: Los sistemas futuros adaptarán cada vez más sus respuestas no solo al contexto inmediato, sino también al estilo de comunicación, las preferencias, el nivel de conocimiento y el historial de relaciones de cada usuario. Esta personalización hará que las interacciones se sientan más naturales y relevantes, aunque plantea importantes preguntas sobre la privacidad y el uso de datos.

Inteligencia emocional: Si bien los sistemas actuales pueden detectar sentimientos básicos, la IA conversacional del futuro desarrollará una inteligencia emocional más sofisticada: reconocerá estados emocionales sutiles, responderá adecuadamente a la angustia o la frustración y adaptará su tono y enfoque en consecuencia. Esta capacidad será especialmente valiosa en aplicaciones de atención al cliente, atención médica y educación.

Asistencia proactiva: En lugar de esperar consultas explícitas, los sistemas conversacionales de próxima generación anticiparán las necesidades basándose en el contexto, el historial del usuario y las señales del entorno. Un sistema podría detectar que está programando varias reuniones en una ciudad desconocida y ofrecer proactivamente opciones de transporte o pronósticos del tiempo. Integración multimodal fluida: Los sistemas futuros irán más allá de la simple compatibilidad con diferentes modalidades, integrándolas a la perfección. Una conversación podría fluir con naturalidad entre texto, voz, imágenes y elementos interactivos, eligiendo la modalidad adecuada para cada dato sin necesidad de una selección explícita del usuario.

Expertos en dominios especializados: Si bien los asistentes de propósito general seguirán mejorando, también veremos el auge de la IA conversacional altamente especializada con una profunda experiencia en dominios específicos: asistentes legales que comprenden la jurisprudencia y los precedentes, sistemas médicos con un amplio conocimiento de las interacciones farmacológicas y los protocolos de tratamiento, o asesores financieros versados en códigos tributarios y estrategias de inversión.

Aprendizaje verdaderamente continuo: Los sistemas futuros irán más allá del reentrenamiento periódico hacia el aprendizaje continuo a partir de las interacciones, volviéndose más útiles y personalizados con el tiempo, manteniendo al mismo tiempo las garantías de privacidad adecuadas.

A pesar de estas emocionantes posibilidades, persisten los desafíos. Las preocupaciones sobre la privacidad, la mitigación de sesgos, la transparencia adecuada y el establecimiento del nivel adecuado de supervisión humana son problemas constantes que definirán tanto la tecnología como su regulación. Las implementaciones más exitosas serán aquellas que aborden estos desafíos de forma reflexiva y, al mismo tiempo, ofrezcan un valor genuino a los usuarios. Lo que está claro es que la IA conversacional ha pasado de ser una tecnología de nicho a un paradigma de interfaz generalizado que mediará cada vez más en nuestras interacciones con los sistemas digitales. La evolución desde la sencilla coincidencia de patrones de ELIZA hasta los sofisticados modelos lingüísticos actuales representa uno de los avances más significativos en la interacción humano-computadora, y el camino está lejos de terminar.