Pruebe la IA en SU sitio web en 60 segundos

Vea cómo nuestra IA analiza instantáneamente su sitio web y crea un chatbot personalizado - sin registro. ¡Simplemente ingrese su URL y observe cómo funciona!

La evolución de la interacción humano-computadora

Esta evolución representa uno de los cambios más significativos en la interacción humano-computadora desde que la interfaz gráfica de usuario reemplazó las líneas de comandos. Durante décadas, adaptamos nuestro comportamiento para adaptarnos a las limitaciones de la tecnología: escribir comandos con un formato preciso, navegar por estructuras de menú complejas y aprender interfaces especializadas. Ahora, la tecnología finalmente se está adaptando a nuestros métodos naturales de comunicación.

El auge de los chatbots multimodales (sistemas de IA que pueden procesar y responder a través de múltiples canales simultáneamente) marca un punto de inflexión en este camino. Estos sistemas no solo entienden las palabras habladas; Interpretan el tono, reconocen imágenes, responden a gestos y mantienen el contexto en diferentes modos de interacción. Como señala la Dra. Maya Ramírez, directora de investigación de IA conversacional en Stanford: «Estamos pasando de enseñar a los humanos a hablar como una computadora a enseñar a las computadoras a entender a los humanos».

Este cambio no se ha producido de la noche a la mañana. Ha sido impulsado por avances convergentes en el reconocimiento de voz, el procesamiento del lenguaje natural, la visión artificial y el aprendizaje profundo. El resultado es una tecnología cada vez más invisible, que se integra en nuestra vida cotidiana sin necesidad de adaptar nuestro comportamiento natural.

Más allá del texto: la revolución multimodal

Los chatbots modernos con voz combinan varias capacidades distintivas:

El reconocimiento de voz transforma el lenguaje hablado en texto con una precisión cada vez mayor, incluso en entornos ruidosos o con diversos acentos y dialectos.

La comprensión del lenguaje natural extrae el significado y la intención de las palabras, reconociendo entidades, relaciones y los matices contextuales que le dan al lenguaje su riqueza.

La síntesis de voz genera respuestas cada vez más naturales, con un ritmo, énfasis e incluso matices emocionales adecuados que humanizan las interacciones.

El procesamiento visual permite a los sistemas recibir, interpretar y generar imágenes, videos y otra información visual que complementa la comunicación verbal. La memoria contextual mantiene la comprensión del historial de conversaciones en diferentes modos, lo que permite interacciones más coherentes y relevantes a lo largo del tiempo.

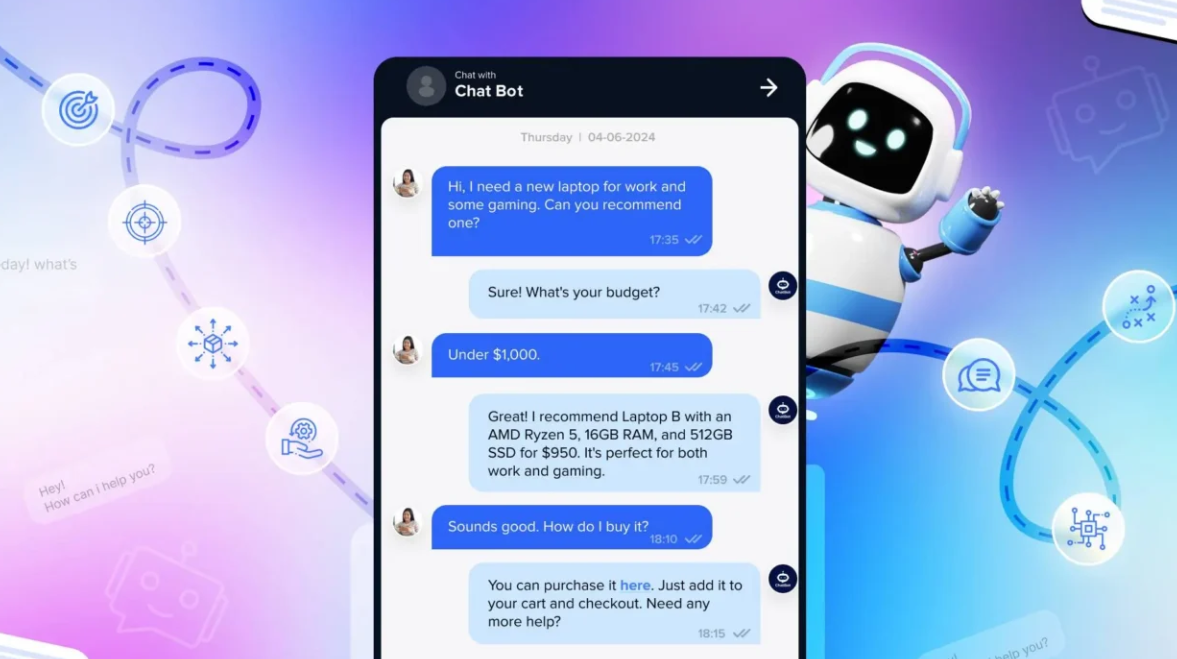

La integración de estas capacidades crea experiencias que se perciben fundamentalmente diferentes a las interacciones de IA anteriores. Tomemos como ejemplo los asistentes de compras virtuales. Un cliente ahora puede pedir ver "algo así, pero en azul", mientras muestra la imagen de un vestido. El asistente puede comprender la referencia visual, procesar la modificación verbal y responder con información visual y oral sobre las opciones disponibles.

Recientemente observé a mi vecina de 78 años, con dificultades con la tecnología, mantener una conversación compleja con su asistente multimodal sobre la reprogramación de citas médicas mientras revisaba simultáneamente conflictos de calendario en su pantalla. La fluidez natural entre voz, elementos visuales y texto hizo que la interacción fuera accesible de una manera que habría sido imposible con las interfaces tradicionales.

La voz como interfaz principal

La accesibilidad ha mejorado significativamente. Las interfaces de voz abren la tecnología a personas con discapacidad visual, movilidad reducida o bajo nivel de alfabetización, así como a quienes encuentran desafiantes las interfaces de texto tradicionales debido a la edad o la discapacidad.

El funcionamiento manos libres permite la interacción al conducir, cocinar, hacer ejercicio o realizar otras actividades donde usar una pantalla sería poco práctico o inseguro.

La velocidad de interacción a menudo supera la del tecleo, especialmente para consultas o comandos complejos. La mayoría de las personas hablan a 150 palabras por minuto, pero escriben a solo 40.

La interacción natural elimina la curva de aprendizaje asociada con las interfaces especializadas. Si puede mantener una conversación, puede utilizar un sistema habilitado por voz.

La conexión emocional tiende a ser más fuerte con las interacciones de voz que con el texto. La voz humana transmite señales emocionales que crean una sensación de presencia social incluso al interactuar con IA. Sarah Johnson, directora de experiencia de usuario (UX) de una importante empresa automotriz, me contó cómo la implementación de interfaces multimodales cambió el comportamiento del conductor: "Cuando reemplazamos las pantallas táctiles con controles de voz mejorados con una simple confirmación visual, observamos una disminución de los incidentes de conducción distraída en más de un 30 %. Los conductores mantuvieron la vista en la carretera mientras accedían a las funciones de navegación, entretenimiento y comunicación".

Las interfaces de voz no están exentas de desafíos. La privacidad surge cuando los dispositivos están siempre escuchando, el ruido ambiental puede interferir con el reconocimiento y el uso en público puede resultar socialmente incómodo. Sin embargo, las mejoras tecnológicas y un diseño inteligente han abordado muchos de estos problemas, contribuyendo a la rápida adopción de la voz como método principal de interacción.

Aplicaciones del mundo real que transforman las industrias

En el ámbito sanitario, los asistentes de voz ayudan a los pacientes a describir síntomas a la vez que analizan señales visuales como afecciones cutáneas o limitaciones de movimiento. Médicos del Hospital General de Massachusetts informaron que su sistema de triaje con IA, que combina entrevistas de voz con análisis de imágenes, mejoró la precisión del diagnóstico inicial en un 22 % en comparación con los cuestionarios estándar.

La atención al cliente se ha revolucionado gracias a sistemas que combinan a la perfección llamadas de voz, chats de texto y demostraciones visuales. Cuando un cliente llama con un problema complejo con un producto, estos sistemas pueden enviar vídeos instructivos o solicitar fotos del problema, manteniendo la continuidad de la conversación.

Las aplicaciones educativas utilizan la interacción de voz combinada con materiales visuales para crear experiencias de aprendizaje más atractivas y accesibles. Una aplicación de aprendizaje de idiomas que probé recientemente utiliza el reconocimiento de voz para evaluar la pronunciación, a la vez que muestra la posición de la boca y ofrece representaciones visuales de conceptos, creando un entorno de aprendizaje multisensorial.

Los entornos minoristas ahora cuentan con asistentes virtuales que pueden hablar sobre productos, mostrar comparaciones y procesar compras mediante una conversación natural. Los asistentes de voz en tienda de Nordstrom pueden comprender consultas como "Muéstrame algo similar a lo que compré el mes pasado, pero más cálido para el invierno", consultando el historial de compras y haciendo recomendaciones contextualmente relevantes.

Las aplicaciones industriales combinan comandos de voz con confirmación visual en entornos donde el uso de manos libres es crucial. Los trabajadores de una planta de ensamblaje de Boeing utilizan sistemas dirigidos por voz que proporcionan guía visual para tareas de ensamblaje complejas, lo que reduce los errores en un 17 % y aumenta la eficiencia.

Los ecosistemas de hogares inteligentes dependen cada vez más de las interacciones multimodales, lo que permite a los usuarios controlar entornos mediante voz natural mientras reciben retroalimentación visual. "Muéstrame quién está en la puerta" activa una respuesta verbal y la visualización de la señal de la cámara, lo que crea una percepción más completa del entorno del hogar.

Las implementaciones más exitosas no consideran la voz simplemente como un método de entrada adicional, sino que rediseñan todo el modelo de interacción en torno a patrones de comunicación naturales. Este enfoque holístico genera experiencias que se sienten intuitivas en lugar de tecnológicas.

La tecnología detrás de la transformación

El reconocimiento de voz avanzado alcanza ahora una precisión superior al 95 % en condiciones ideales gracias a redes neuronales profundas entrenadas con conjuntos de datos masivos de habla humana. Estos sistemas pueden gestionar diferentes acentos, dialectos, impedimentos del habla y ruido de fondo con una robustez cada vez mayor.

La comprensión del lenguaje natural ha evolucionado desde la simple coincidencia de palabras clave hasta modelos sofisticados que captan el contexto, la intención y la sutileza. Los sistemas modernos comprenden referencias ambiguas, rastrean entidades a lo largo de una conversación e interpretan significados implícitos que no se expresan directamente.

Los grandes modelos lingüísticos (LLM) sientan las bases de muchos sistemas multimodales, con arquitecturas que pueden procesar y generar tanto texto como otras modalidades. Estos modelos contienen cientos de miles de millones de parámetros y se entrenan con datos diversos que les ayudan a comprender las relaciones entre diferentes tipos de información.

La síntesis de voz ha evolucionado desde fonemas robóticos e inconexos hasta voces que suenan naturales con la inflexión y la cadencia emocional adecuadas. Los mejores sistemas ahora superan el "valle inquietante", sonando tan humanos que los usuarios olvidan que están hablando con IA.

Las capacidades de visión artificial permiten a los sistemas reconocer objetos, interpretar escenas, comprender gestos y procesar información visual que complementa la interacción de voz. Cuando le preguntas a un asistente multimodal sobre un objeto que sostienes frente a la cámara, múltiples sistemas de IA trabajan en conjunto para ofrecer una respuesta coherente.

Los avances en edge computing han permitido que más procesamiento se realice directamente en los dispositivos en lugar de en la nube, lo que reduce la latencia y aborda las preocupaciones de privacidad sobre el envío de todos los datos de voz a servidores remotos.

Mark Chen, director de tecnología de una empresa líder en IA conversacional, explicó: "El verdadero avance no fue una sola tecnología, sino la integración de múltiples sistemas de IA que pueden compartir contexto y colaborar en tiempo real. Cuando tu asistente de voz puede escuchar tu pregunta sobre un sarpullido en tu brazo y ver el sarpullido en sí, la capacidad de diagnóstico aumenta exponencialmente".

Si bien los componentes individuales, como el reconocimiento de voz, han mejorado drásticamente, la perfecta coordinación de estas tecnologías crea experiencias que superan la suma de sus partes. Los sistemas más avanzados determinan dinámicamente qué modalidades son las más apropiadas para las diferentes partes de una interacción, cambiando fluidamente entre ellas según el contexto y las necesidades del usuario.

Pruebe la IA en SU sitio web en 60 segundos

Vea cómo nuestra IA analiza instantáneamente su sitio web y crea un chatbot personalizado - sin registro. ¡Simplemente ingrese su URL y observe cómo funciona!

Consideraciones éticas e impacto social

La preocupación por la privacidad es particularmente grave con los dispositivos que siempre están escuchando en hogares y lugares de trabajo. Los usuarios a menudo no comprenden completamente cuándo se graban, procesan o almacenan sus conversaciones. Las empresas deben encontrar el equilibrio entre la funcionalidad que requiere escucha y el respeto por los espacios privados.

Los beneficios de la accesibilidad pueden ser transformadores para las personas con discapacidad, pero solo si estos sistemas se diseñan teniendo en cuenta las diversas necesidades desde el principio. Las interfaces de voz que no entienden acentos o impedimentos del habla pueden, de hecho, ampliar la brecha digital en lugar de reducirla.

Las normas sociales en torno a la interacción con la IA siguen evolucionando. A medida que los asistentes de voz se vuelven más parecidos a los humanos, los usuarios pueden desarrollar vínculos emocionales o expectativas que estos sistemas no están diseñados para satisfacer. La línea entre una herramienta útil y una relación social percibida puede difuminarse.

La disrupción del mercado laboral es inevitable a medida que los sistemas de IA de voz reemplazan ciertos roles en atención al cliente, recepción y otros puestos con alta interacción. Si bien surgirán nuevos empleos, la transición podría ser difícil para los trabajadores cuyas habilidades repentinamente tienen menos demanda.

El sesgo algorítmico puede manifestarse en sistemas de voz que entienden ciertos acentos, dialectos o patrones de habla mejor que otros. Si estos sistemas funcionan mal para grupos demográficos específicos, las desigualdades existentes podrían verse reforzadas.

La dependencia tecnológica plantea interrogantes sobre qué sucede cuando externalizamos más funciones cognitivas e interactivas a sistemas de IA. Algunos investigadores expresan su preocupación por la pérdida de ciertas capacidades humanas a medida que dependemos más de la asistencia tecnológica.

La Dra. Elena Washington, especialista en ética de la IA, compartió su perspectiva: «La IA de voz es inherentemente más íntima que las interfaces de texto. Entra en nuestros hogares, escucha nuestras conversaciones y nos habla con voces humanas. Esto genera oportunidades y responsabilidad. Estos sistemas necesitan barreras éticas que se ajusten a su acceso sin precedentes a nuestras vidas». Las organizaciones con visión de futuro están abordando estas preocupaciones mediante la transparencia en el uso de datos, políticas de suscripción voluntaria para la grabación de voz, datos de entrenamiento diversos para reducir el sesgo y una señalización clara cuando los usuarios interactúan con IA en lugar de humanos. La industria está reconociendo gradualmente que el éxito a largo plazo depende no solo de la capacidad técnica, sino también de ganarse y mantener la confianza del usuario.

Desafíos del diseño de la experiencia del usuario

El diseño de conversaciones requiere un enfoque fundamentalmente distinto al diseño de interfaz visual. Las conversaciones son temporales, no espaciales, y los usuarios no pueden explorar las opciones disponibles como lo harían en una pantalla. Los diseñadores deben crear experiencias que guíen a los usuarios de forma natural, sin abrumarlos con opciones o información.

La gestión de errores se vuelve más compleja cuando la voz es la interfaz principal. A diferencia de un clic erróneo, que puede corregirse de inmediato, los errores de reconocimiento de voz pueden arruinar interacciones enteras. Los sistemas eficaces deben confirmar con precisión la información crítica y proporcionar vías de recuperación cuando se produzcan malentendidos.

La coordinación multimodal requiere una orquestación cuidadosa de los diferentes canales de comunicación. ¿Cuándo debe presentarse la información visualmente o verbalmente? ¿Cómo se complementan estos canales en lugar de competir entre sí? Estas preguntas requieren decisiones de diseño meditadas basadas en principios cognitivos y pruebas de usuario.

La personalidad y el tono influyen significativamente en la percepción del usuario de las interfaces de voz. A diferencia de las interfaces visuales, donde la personalidad es menos prominente, la voz transmite de forma natural los rasgos de carácter. Las organizaciones deben decidir qué atributos de personalidad se alinean con su marca e implementarlos de forma coherente. La conciencia del contexto se vuelve esencial para las interacciones naturales. Los sistemas necesitan comprender no solo lo que dicen los usuarios, sino también cuándo y dónde lo dicen, ajustando las respuestas en función de factores ambientales, la hora del día, el historial del usuario y otros elementos contextuales.

Jamie Rivera, quien lidera el diseño de experiencias de voz en una importante empresa tecnológica, describió su enfoque: «Pasamos meses determinando cuándo usar solo la voz, cuándo añadir elementos visuales y cuándo hacer la transición de los usuarios a una experiencia centrada en la pantalla. La respuesta correcta varía no solo según la tarea, sino también según el usuario, el entorno y el contexto. Nuestro sistema de diseño ahora incluye árboles de decisión para la selección de modalidades que tienen en cuenta docenas de variables».

Los diseños más exitosos no se limitan a traducir las interacciones basadas en pantalla a voz, sino que replantean todo el modelo de interacción basándose en principios de conversación. Esto a menudo implica menos opciones presentadas a la vez, mayor confirmación de acciones críticas y una cuidadosa atención a las limitaciones de memoria en contextos de solo audio.

El panorama futuro: tendencias emergentes

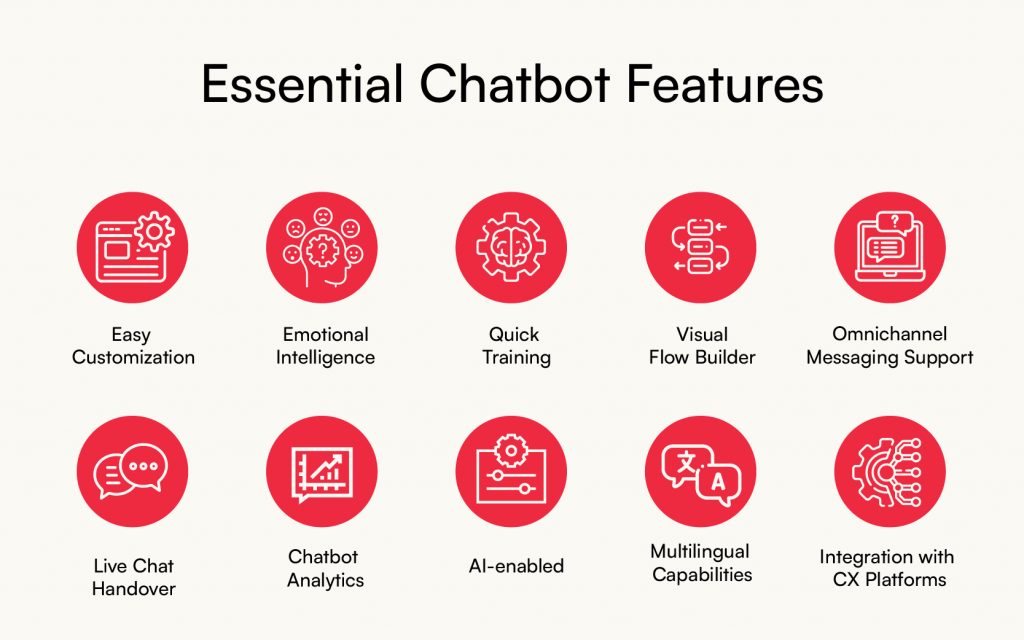

La inteligencia emocional se está convirtiendo en un factor diferenciador clave a medida que los sistemas van más allá de la precisión funcional para reconocer y responder adecuadamente a las emociones humanas. Los sistemas de voz avanzados detectan frustración, confusión o satisfacción en las voces de los usuarios y ajustan sus respuestas en consecuencia.

La personalización se vuelve más sofisticada a medida que los sistemas construyen modelos de usuario integrales en todas las interacciones. En lugar de tratar cada conversación como algo aislado, los sistemas futuros comprenderán las preferencias, los estilos de comunicación y las necesidades del usuario a lo largo del tiempo, creando experiencias cada vez más personalizadas.

La inteligencia ambiental visualiza entornos donde la voz y la IA multimodal se integran a la perfección en los espacios físicos, disponibles cuando se necesitan, pero invisibles cuando no. En lugar de activar dispositivos explícitamente, los usuarios navegarán por un entorno que responde a la comunicación natural.

Están surgiendo interfaces de voz especializadas para dominios específicos como la salud, el derecho y la educación, con un profundo conocimiento de la terminología y los flujos de trabajo específicos de cada campo. Estos sistemas especializados logran mayor precisión y utilidad dentro de sus dominios que los asistentes de propósito general. La IA de voz descentralizada está ganando terreno a medida que la preocupación por la privacidad impulsa el desarrollo de sistemas que procesan la voz localmente en lugar de enviar datos a servidores en la nube. Este enfoque reduce la latencia y conserva los datos de voz potencialmente sensibles en los dispositivos del usuario.

La continuidad entre dispositivos permite que las conversaciones fluyan con naturalidad en diferentes entornos y dispositivos. Una conversación iniciada con un altavoz inteligente puede pasar sin problemas a un coche y luego a un teléfono, manteniendo el contexto completo en todo momento.

El profesor Tariq Johnson, investigador de interfaces de próxima generación en el MIT Media Lab, predice: «Dentro de cinco años, la distinción entre los diferentes modos de interacción será casi irrelevante para los usuarios. Simplemente se comunicarán de forma natural y su entorno tecnológico responderá adecuadamente, a veces mediante la voz, a veces visualmente, a veces hápticamente, a menudo mediante combinaciones determinadas por las particularidades de la situación».

Esta convergencia sugiere un futuro en el que la tecnología en sí misma se aleja de la conciencia, y la atención humana se centra en las tareas y los objetivos en lugar de en las interfaces utilizadas para lograrlos.

Conclusión: El futuro conversacional

Esta transformación conlleva profundas implicaciones. Para los usuarios, implica interacciones más intuitivas, accesibles y eficientes. Para los desarrolladores y diseñadores, requiere replantear los modelos de interacción en torno a la conversación en lugar de la manipulación. Para las organizaciones, ofrece oportunidades para crear relaciones más personales y atractivas con los clientes, a la vez que aborda nuevas consideraciones éticas y de privacidad.

Las implementaciones más exitosas serán aquellas que combinen cuidadosamente diferentes modalidades en función del contexto, las necesidades del usuario y los factores del entorno. La voz suele liderar estas interacciones, pero los componentes visuales, gestuales y textuales complementarán el habla de forma que se aprovechen las fortalezas de cada canal de comunicación.

A medida que estos sistemas continúan evolucionando, la línea entre las interacciones digitales y físicas se difuminará aún más. Nuestros asistentes digitales serán más sensibles al contexto, emocionalmente inteligentes y se adaptarán a nuestras necesidades individuales. La tecnología en sí misma se irá desvaneciendo a medida que la experiencia se vuelva más humana.

El futuro conversacional prometido por la ciencia ficción durante décadas finalmente está emergiendo, no mediante un único avance, sino mediante la cuidadosa integración de avances en múltiples dominios. La IA multimodal habilitada por voz no solo está cambiando nuestra forma de interactuar con la tecnología; está redefiniendo el significado de la interacción tecnológica en nuestra vida diaria.